해당 게시물은 Edwith에서 제공하는

머신러닝과 딥러닝 BASIC을 듣고 요약 정리한 글입니다.

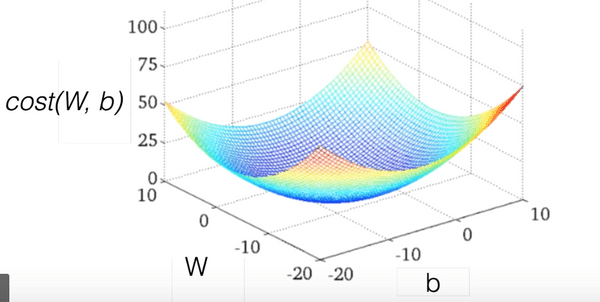

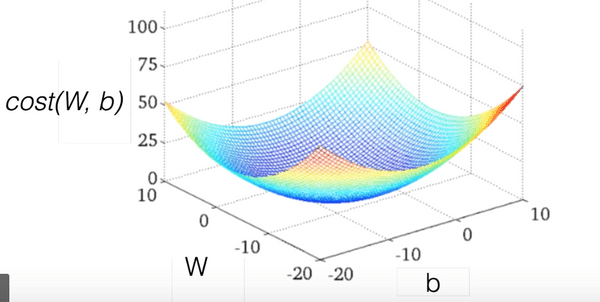

Hypothesis and Cost

H(x)=Wx+b

cost(W,b)=m1∑_i=1m(H(x(i))−y(i))2

Simplified hypothesis

H(x)=Wx

cost(W)=m1∑_i=1m(Wx(i)−y(i))2

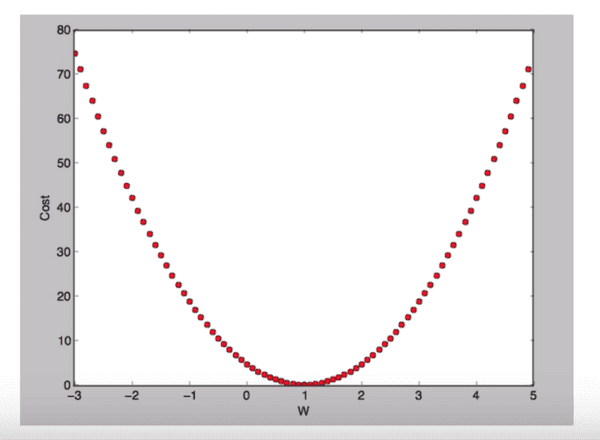

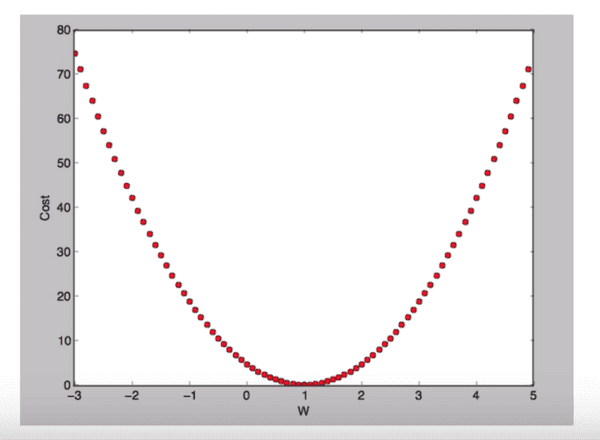

What cost(W) looks like?

W = 1, cost(W) = ?

Cost(W)=(11−1)2+(12−2)2+(1∗3−3)=0

W = 0, cost(W) = 4.67

Cost(W)=31((01−1)2+(02−2)2+(0∗3−3)2)=4.67

W = 2, cost(W) = 4.67

Cost(W)=31((21−1)2+(22−2)2+(2∗3−3)2)=4.67

W값의 변화에 따라 달라지는 cost(W)의 값 그래프

우리의 목표 : cost(W)가 최소화 되는 점을 찾는 것

Gradient descent algorithm

- 경사하강법

cost(W)의 최솟값을 찾는데 사용- 아무 지점에서나 시작 가능

W의 값을 조금씩 줄이며 cost(W)의 값을 계산- 반복적인 작업

- 경사도를 구하는 법 : 미분

cost(W,b)=2m1∑_i=1m(H(x(i))−y(i))2

W:=W−aaWacost(W)

미분 과정

1.

W:=W−aaWa2m1∑_i=1m(Wx(i)−y(i))2

2.

W:=W−a2m1∑_i=1m2(Wx(i)−y(i))x(i)

3.

W:=W−am1∑_i=1m(Wx(i)−y(i))x(i)

Convex function

- 경사하강법을 사용할 때 그래프가 아래와 같은 모양인지 확인 필수